História[editar]

Foi concebida teoricamente em 1948 pelo húngaro Dennis Gabor, vencedor do Prémio Nobel de Física em 1971, e executada pela primeira vez somente nos anos 60, após a invenção do laser. Além de servir como forma de registro de imagens ela também é utilizada pela Física como uma sofisticada técnica para análise de materiais e armazenamento de dados.

O nome Holografia vem do grego holos (todo, inteiro) e graphos (sinal, escrita), pois é um método de registo "integral" da informação com relevo e profundidade.

Os hologramas possuem uma característica única: cada parte deles possui a informação do todo. Assim, um pequeno pedaço de um holograma terá informações de toda a imagem do mesmo holograma completo. Ela poderá ser vista na íntegra, mas a partir de um ângulo restrito. A comparação pode ser feita com uma janela: se a cobrirmos, deixando um pequeno buraco na cobertura, permitiremos a um espectador continuar a observar a paisagem do outro lado. Porém, por conta do buraco, de um ângulo muito restrito; mas ainda se conseguirá ver a paisagem.

Este conceito de registro "total", no qual cada parte possui a informações do todo, é utilizado em outras áreas, como na Neurologia, na Neuro-fisiologia e na Neuro-psicologia, para explicar como o cérebro armazena as informações ou como a nossa memória funciona.

Desta forma, a holografia não deve ser considerada simplesmente como mais uma forma de visualização de imagens em três dimensões, mas sim como um processo de se codificar uma informação visual e depois (através do laser) decodificá-la, recriando "integralmente" esta mesma informação. É importante notar que diversas formas de projecção são erroneamente chamadas de holográficas por resultarem em imagens que aparentemente estão no ar (projecções sobre telas transparentes, películas de água, fumaça ou óleo). Na verdade, o sentido da holografia é o da reconstrução e da integralidade da imagem e não de uma impressão visual fantasmagórica que geralmente é em duas dimensões. Até hoje, não existe uma forma de projecção de imagens no ar sem qualquer suporte, seja ela holográfica ou não.

O termo holografia também é conhecido por holograma, que quer dizer "registro inteiro" ou "registro integral".

Método de Dennis Gabor[editar]

Este método usa lentes para abrir os raios e assim iluminar propriamente o objecto. Divide-se o laser em dois feixes por meio de um espelho que reflete apenas parcialmente a luz. O primeiro raio ilumina o objecto e faz sua imagem chegar ao filme fotográfico; o outro é direccionado por um segundo espelho e incide directamente sobre o filme. Há então um cruzamento dos dois raios sobre a superfície do filme (aquele com a imagem do objecto e o que atingiu directamente) fazendo com que as ondas de luz interfiram umas nas outras. Onde as cristas das ondas se encontram, forma-se luz mais intensa; onde uma crista de um feixe encontra o intervalo de onda de outro, forma-se uma região escura. Esta sobreposição é possível porque o laser se propaga através de ondas paralelas e igualmente espaçadas. O resultado é codificação da luz que atingia o objecto resultando em uma imagem tridimensional que reproduz o objecto fielmente. Porém ela só é vista quando se ilumina este filme com um laser. Para que esta imagem seja vista com a luz branca normal é preciso fazer todo processo novamente, só que desta vez substituindo o objecto pelo filme que já contém a imagem holográfica. Assim, coloca-se o filme exposto e revelado no lugar do objecto a ser holografado e um outro filme virgem que receberá a imagem através dos dois feixes. O resultado é um holograma visível sob a luz branca. Na verdade, pode-se considerar a holografia como uma "reconstrução luminosa do objecto" em três dimensões. A técnica de Gabor foi aperfeiçoada ao longo do tempo por outros cientistas como Stephen Benton, o que permitiu uma difusão da holografia fazendo com que fosse utilizada em diversas áreas. Os hologramas podem ser reproduzidos em película fotográfica, películas plásticas especiais ou em poliéster metalizado (hologramas impressos).

Áreas de utilização[editar]

A holografia é usada dentro da pesquisa científica no estudo de materiais, desenvolvimento de instrumentos ópticos, criação de redes de difracção entre outras. Na área da indústria tem aplicações no controle de qualidade de materiais, armazenamento de informação e na segurança (vide textos abaixo). A holografia também é utilizada na área da comunicação como um "display" de alto impacto visual comercialmente usado como elemento promocional em pontos-de-venda, estandes, museus, exposições, etc.

Já nas artes visuais diversos artistas trabalham a holografia como uma forma de expressão.

Os pioneiros da holografia no Brasil foram o Prof. José Lunazzi, da UNICAMP, o artista plástico e videomaker Moysés Baumstein e Fernando Catta-Preta. Baumstein produziu mais de 200 hologramas comerciais para empresas, instituições e agências de promoção, além de inúmeras holografias artísticas.

Armazenamento de dados[editar]

A possibilidade de armazenar grandes quantidades de informação em algum tipo de meio é de grande importância, para arquivamento, processamento de informações ou de imagens. Na área da tecnologia da informação testa-se o uso de hologramas como uma forma "ótica" de armazenamento de dados, que permite armazenar uma alta densidade de informações em cristais ou foto-polímeros. Como desdobramento destes testes, uma nova geração de DVDs foi criada pelo Bell Labs dos Estados Unidos e por outros laboratórios pelo mundo com base nos princípios holográficos. Enquanto os aparelhos de DVD atuais (incluindo o Blu-Ray e o extinto HD-DVD) lêem e gravam as informações no disco em uma ou mais camadas através de um sistema que altera o foco do raio laser, foi criado um novo disco onde o raio é dividido, alterado e recombinado de modo a criar padrões de interferência. Estes padrões na verdade são pequenos hologramas gravados por toda a camada sensível do disco que ocupam um espaço muito pequeno. Assim pode-se gravar uma densidade enorme de informação chegando-se ao patamar de Terabytes de dados (trilhões de bytes) em um único disco. Isto equivaleria a uma capacidade de armazenamento 800 vezes maior do que a de um DVD normal armazena hoje. Este tipo de DVD ainda experimental é chamado de Holographic Versatile Disc, ou Disco Holográfico Versátil.

Segurança[editar]

O uso de hologramas impressos (imagens holográficas estampadas em base de poliester ou em suportes "destrutíveis") para segurança se dá porque é muito difícil de produzir e replicar estes tipos de hologramas, assim eles são aplicados em produtos como um selo que comprovaria sua autenticidade. Porém apesar de requerer equipamentos caros, especializados e avançados tecnologicamente, nos últimos anos apareceram diversas falsificações de produtos com selos holográficos provando que se o valor do produto compensa a pirataria também investe em alta tecnologia. Os hologramas mais comuns para segurança são adesivos aplicados em cartões de crédito e bancários, em produtos de informática, relógios, DVDs e vários outros produtos passíveis de pirataria. De forma mais sofisticada hologramas impressos são integrados ao papel moeda para aumentar o grau de segurança de notas, acções, certificados bancários. Atualmente as notas de R$20, de R$50 e R$100 reais no Brasil, de 5/10/20 libras na Inglaterra, 5/10/20/50/100 dólares canadenses no Canadá, 5000/10000 yens no Japão, possuem tiras holográficas impressas.

Artes visuais[editar]

Como forma de expressão artística a holografia ainda é considerada embrionária, uma estética holográfica está por ser desenvolvida, porém diversos artistas plásticos a utilizaram, entre eles a inglesa Margaret Benyon, os norte-americanos Rudie Berkhout e Harriet Casdin-Silver, os brasileiros Moysés Baumstein, Augusto de Campos, Décio Pignatari e a japonesa Setsuko Ishii. A primeira exposição de hologramas no Brasil foi organizada pelo produtor cultural Ivan Isola em 1981 no pavilhão da Bienal em São Paulo com hologramas produzidos em diversos países. Isola também criou a primeira sala de exposições dedicada a holografia durante sua gestão como diretor do MIS Museu da Imagem e do Som de São Paulo.

Em 1982 Moysés Baumstein (1931-1991) montou o primeiro de seus dois laboratórios em São Paulo dirigidos à produção holográfica artística e comercial. Desenvolveu técnicas próprias de exposição e revelação, que resultaram em hologramas de grande impacto visual e qualidade. Em 1987 montou seu segundo laboratório, no total foram produzidos nos dois laboratórios mais de 300 hologramas tanto para uso comercial quanto artístico.

Do final da década de 1980 até sua morte Moysés Baumstein trabalhou com Augusto de Campos, Décio Pignatari, Júlio Plaza, Wagner Garcia e Rozélia Medeiros produzindo e expondo Hologramas artísticos em diversos museus e instituições no Brasil e no exterior; seu laboratório esteve em atividade até 2007, quando foi doado para o setor de Óptica da Universidade UNICAMP.

A holografia também gerou conhecidos "ídolos" atuais japoneses, como os Vocaloids.

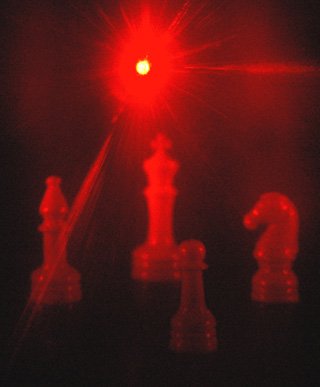

Holography - Is "lensless photography"

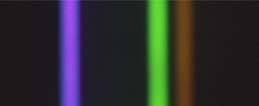

The above image was taken through a transmission hologram. The hologram was illuminated from behind by a helium-neon laser which has been passed through a diverging lens to spread the beam over the hologram.

Holography is "lensless photography" in which an image is captured not as an image focused on film, but as an interference pattern at the film. Typically, coherent light from a laser is reflected from an object and combined at the film with light from a reference beam. This recorded interference pattern actually contains much more information that a focused image, and enables the viewer to view a true three-dimensional image which exhibits parallax.

That is, the image will change its appearance if you look at it from a different angle, just as if you were looking at a real 3D object. In the case of a transmission hologram, you look through the film and see the three dimensional image suspended in midair at a point which corresponds to the position of the real object which was photographed.

|  |  |

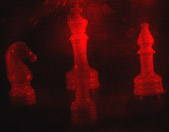

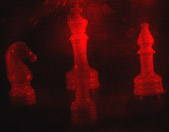

These three images of the same hologram were taken by positioning the camera at three positions, moving the camera from left to right. Note that the pawn appears on the right side of the king in the left photo, but transitions to the left of the king as you move the viewing position across the hologram so that you are viewing it from further to the right. This is real parallax, which tells you that the image is truly 3-dimensional. Each perspective corresponds to looking through the hologram at a particular point.

The Holographic Image

Some of the descriptions of holograms are

- "image formation by wavefront reconstruction.."

- "lensless photography"

- "freezing an image on its way to your eye, and then reconstructing it with a laser"

A consistent characteristic of the images as viewed

- The images are true three-dimensional images, showing depth and parallax and continually changing in aspect with the viewing angle.

- Any part of the hologram contains the whole image!

- The images are scalable. They can be made with one wavelength and viewed with another, with the possibility of magnification.

Three-Dimensional Image

Holograms are true three-dimensional images. This is evidenced by the fact that you can move your head while viewing the image and see it in a different perspective. This includes revealing part of the image which was hidden at another viewing angle. Shown below are three images from the same hologram, obtained by looking through it at different angles. Note that the pawn appears in different perspective in front of the king behind it.

|  |

When a piece is the whole

Every part of a hologram contains the image of the whole object. You can cut off the corner of a hologram and see the entire image through it. For every viewing angle you see the image in a different perspective, as you would a real object. Each piece of a hologram contains a particular perspective of the image, but it includes the entire object.

The image at upper right is the view through the larger part of the hologram, while that at lower right is through a small corner cut off the hologram. While the view through the small corner is from a particular point of view, it contains the whole object.

|   |

Image on the Film of a Hologram

|

The image on the film for a transmission hologram is formed by the interference of the light from the object and the reference beam. This interference pattern looks something like the ripples on a pond when a bunch of small pebbles is thrown in. The interference pattern on this hologram is extraordinarily well defined.

|

Viewing a transmission holograminvolves illuminating it with a coherent source like a laser and looking through the film at the image in space behind the film. The image shown is associated with the interference pattern above.

|  |

Scaling Holographic Images

The holographic image scales with the wavelength. This initially caused great excitement because one could imagine making holographic images with x-rays and viewing them with visible light, getting three-dimensional views of things on the scale of molecules. X-ray holograms have yet to be made, and there are practical difficulties with the scaling, but there is still the possibility that this feature of holograms will prove to be of great benefit.

Hologram Scaling with Wavelength

|

One of the unique properties of hologramsis that the size of the viewed image scales with the wavelength of the viewing light. At left is a view of a hologram of the end of a pipe formed with light from a mercury vapor tube. The mercury source has three prominent wavelengths and you can see three distinct images of different size.

Measuring the relative size of the images compared to the blue image (435.8 nm) gives 1.26 for the green (546.1 nm) and 1.36 for the yellow-orange image (576.9 and 579.1 nm). The scaling of the wavelengths relative to the blue wavelength gives 1.25 for the green and an average of 1.33 for the yellow-orange lines, so the image sizes appear to scale with the wavelength.

The lower image shows the same hologram viewed with the mercury source filtered by an interference filter which transmits only the mercury green line.

|

The direct viewing of a hologram with mercury light illustrates a unique feature of the blue vision of the human eye compared to that for red and green. Because of distinctions with the blue cones of the eye and a bit of chromatic aberration in the eye, the blue image will look less distinct than the green and orange image. The effect must be viewed directly; the way the image is made in this illustration mixes in enough other colors to remove the effect.

Interference Imaging

Holography is "lensless photography" in which an image is captured not as an image focused on film, but as an interference pattern at the film.

The Transmission Hologram

The coherent light from the laser is split to form an object beam and a reference beam. The light from the illuminated object and the reference beam form aninterference pattern on the film. This pattern (hologram) contains the information about the object which can then be viewed as at hree dimensional image.

|  |

Reflection Holograms

With a reflection hologram, the image is stored in a thick emulsion and can be viewed in white light. The simplest such hologram to make is the direct beam reflection hologram. In this case the direct beam through the film serves as the reference beam.

Rainbow holograms are holograms which can be viewed in white light. They are made by a double holographic process where an ordinary hologram such as a transmission hologram is used as the object and a second hologram is made through a slit. A horizontal slit limits the vertical perspective of the first image so that there is no vertical parallax in the resultant rainbow hologram.

This slit process removes the coherence requirement on the viewing light so that full advantage can be taken of the image brightness obtained from ordinary room light, while maintaining the three-dimensional character of the image as the viewers eye is moved horizontally. If the viewers eye is moved vertically, no parallax is seen and the image color sweeps through the rainbow spectrum from blue to red, hence "rainbow hologram".

Viewing a Transmission Hologram

Holography is lensless photography. The image is captured in theinterference pattern on the film, and the image can be reconstructed for viewing by shining the coherent light of a laser on the hologram. The eye is focused behind the film to see the image suspended in space. It shows the unique characteristics of holographic images.

Denisyuk contributed to the development of the hologram by using Lippmann's photographic process to make reflection holograms which could be viewed in color if more than one coherent source was available. In his method the beam was passed through the photographic emulsion and back reflected from the object. The emulsion could then be mounted on a reflective backing for viewing by reflected light.

|  |

Above are two views of a Denisyuk demonstration hologram. It is composed of a very thick emulsion mounted on a reflective backing. At first glance it will look like a black, shiny piece of film. But with an overhead light, you can find a position where the image will appear, as shown above right. You can see the image with ordinary room light because of the action of the thick emulsion.

|

Optimum viewing of the holographic image was found with a small flashlight held back as far as practicable from the image. The photo at left was taken under those conditions. The depth of field of the image depends upon the vergence of the light from the source.

|

This view of the same image was photographed with the flashlight close to the hologram. Although it is brighter, there is severe loss of depth of focus. The marching band figurines are also viewed from a different angle, showing the true 3-dimensional nature of the holographic image.

|  |

|  |

When you moved the light source across the hologram, you got dramatic changes in the perspective of the image, showing the true three dimensional nature of the holographic image. Hecht describes this kind of hologram as a "volume hologram" because the emulsion thickness is so great that the object beam and reference beam overlap to produce a three-dimensional pattern of standing waves in the emulsion. The holographic information is stored throughout the volume of the emulsion.

Hologram History

Historical notes:

Gabor was the discoverer of the hologram and received the Nobel Prize in Physics for it in 1971. This was pre-laser holography of course, and he made holograms only of transparencies where his reference beam was the unobstructed light which went through the clear parts of the transparency.

Leith and Upatnieks developed the off-axis reference beam method which is most often used today. It permitted the making of holograms of solid objects by reflected light.

Denisyuk contributed to the development by using Lippmann's photographic process to make reflection holograms which could be viewed in color if more than one coherent source was available. In his method the beam was passed through the photographic emulsion and back reflected from the object. The emulsion could then be mounted on a reflective backing for viewing by reflected light.

Benton is credited with the development of the rainbow hologram. Since it can be mass-copied and viewed with incoherent white light, it has become the most common type of hologram. Rainbow holograms have appeared on National Geographic's cover and on millions of credit cards as a deterrent to counterfeiting.

Composite holograms are made as multiple strips so that you get a different image from different angles. They can be viewed in white light.

Ver artigo principal:

Ver artigo principal: